Hugging Face “datu kopu” bibliotēka nodrošina ērtu veidu, kā strādāt ar datu kopām un manipulēt ar tām dabiskās valodas apstrādes uzdevumiem. Viena noderīga funkcija, ko piedāvā bibliotēka, ir concatenate_datasets(), kas ļauj apvienot vairākas datu kopas vienā datu kopā. Tālāk ir sniegts īss pārskats par funkciju concatenate_datasets() un to, kā to izmantot.

concatenate_datasets()

Apraksts:

Hugging Face “datu kopu” bibliotēka nodrošina concatenate_datasets() funkciju. To izmanto, lai savienotu vairākas datu kopas, apvienojot tās vienā datu kopā pa noteiktu asi. Šī funkcija ir īpaši noderīga, ja jums ir vairākas datu kopas, kurām ir vienāda struktūra, un vēlaties tās apvienot vienotā datu kopā turpmākai apstrādei un analīzei.

Sintakse:

no datu kopas imports concatenate_datasets

concatenated_dataset = concatenate_datasets ( datu kopas , ass = 0 , info = Nav )

Parametri:

datu kopas (datu kopu saraksts): to datu kopu saraksts, kuras vēlaties savienot. Šīm datu kopām ir jābūt saderīgām funkcijām, kas nozīmē, ka tām ir vienāda shēma, kolonnu nosaukumi un datu tipi.

ass (int, neobligāti, noklusējuma = 0): ass, pa kuru jāveic savienošana. Lielākajai daļai NLP datu kopu tiek izmantota noklusējuma vērtība 0, kas nozīmē, ka datu kopas ir savienotas vertikāli. Ja iestatāt ass = 1, datu kopas tiek savienotas horizontāli, pieņemot, ka tām ir dažādas kolonnas kā līdzekļi.

info (datasets.DatasetInfo, neobligāts): informācija par sasaistīto datu kopu. Ja informācija nav norādīta, informācija tiek iegūta no pirmās datu kopas sarakstā.

Atgriež:

concatenated_dataset (Datu kopa): iegūtā datu kopa pēc visu ievades datu kopu savienošanas.

Piemērs:

# 1. darbība. Instalējiet datu kopu bibliotēku# Varat to instalēt, izmantojot pip:

# !pip instalēšanas datu kopas

# 2. darbība. Importējiet nepieciešamās bibliotēkas

no datu kopas imports load_dataset , concatenate_datasets

# 3. darbība: ielādējiet IMDb filmu apskatu datu kopas

# Mēs izmantosim divas IMDb datu kopas, vienu pozitīvām atsauksmēm

#un vēl par negatīvām atsauksmēm.

# Ielādējiet 2500 pozitīvas atsauksmes

datu kopa_poz = load_dataset ( 'imdb' , sadalīt = 'vilciens[:2500]' )

# Ielādējiet 2500 negatīvas atsauksmes

dataset_neg = load_dataset ( 'imdb' , sadalīt = 'vilciens[-2500:]' )

# 4. darbība. Savienojiet datu kopas

# Mēs savienojam abas datu kopas pa axis=0, kā tas ir

tā pati shēma ( tās pašas funkcijas ) .

concatenated_dataset = concatenate_datasets ( [ datu kopa_poz , dataset_neg ] )

# 5. darbība. Analizējiet sasaistīto datu kopu

# Vienkāršības labad saskaitīsim pozitīvo un negatīvo skaitu

# atsauksmes savienotajā datu kopā.

pozitīvo_atsauksmju skaits = summa ( 1 priekš etiķete iekšā

concatenated_dataset [ 'etiķete' ] ja etiķete == 1 )

negatīvo_atsauksmju skaits = summa ( 1 priekš etiķete iekšā

concatenated_dataset [ 'etiķete' ] ja etiķete == 0 )

# 6. darbība. Parādiet rezultātus

drukāt ( 'Pozitīvo atsauksmju skaits:' , pozitīvo_atsauksmju skaits )

drukāt ( 'Negatīvo atsauksmju skaits:' , negatīvo_atsauksmju skaits )

# 7. darbība. Izdrukājiet dažus pārskatu piemērus no savienotās datu kopas

drukāt ( ' \n Daži atsauksmju piemēri:' )

priekš i iekšā diapazons ( 5 ) :

drukāt ( f 'Pārskatīt {i + 1}: {concatenated_dataset['text'][i]}' )

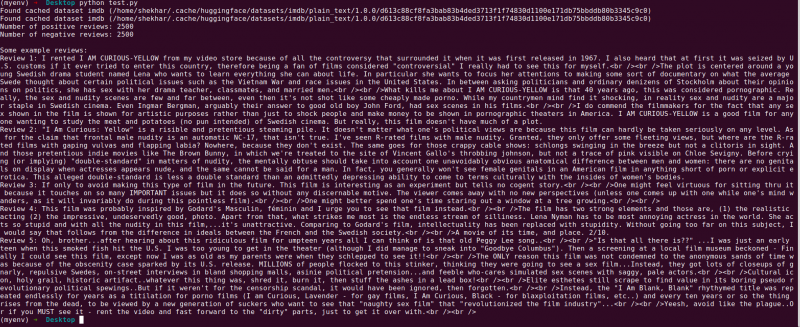

Izvade:

Tālāk ir sniegts skaidrojums Hugging Face “datu kopu” bibliotēkas programmai, kas savieno divas IMDb filmu apskatu datu kopas. Tas izskaidro programmas mērķi, tās lietošanu un koda darbības.

Sniegsim sīkāku skaidrojumu par katru koda darbību:

# 1. darbība. Importējiet nepieciešamās bibliotēkasno datu kopas imports load_dataset , concatenate_datasets

Šajā darbībā mēs importējam programmai nepieciešamās bibliotēkas. Mums ir nepieciešama funkcija “load_dataset”, lai ielādētu IMDb filmu apskatu datu kopas, un “concatenate_datasets”, lai tās vēlāk savienotu.

# 2. darbība: ielādējiet IMDb filmu apskata datu kopas# Ielādējiet 2500 pozitīvas atsauksmes

datu kopa_poz = load_dataset ( 'imdb' , sadalīt = 'vilciens[:2500]' )

# Ielādējiet 2500 negatīvas atsauksmes

dataset_neg = load_dataset ( 'imdb' , sadalīt = 'vilciens[-2500:]' )

Šeit mēs izmantojam funkciju “load_dataset”, lai iegūtu divas IMDb datu kopas apakškopas. “Dataset_pos” satur 2500 pozitīvu atsauksmju, bet “dataset_neg” satur 2500 negatīvas atsauksmes. Mēs izmantojam sadalīto parametru, lai norādītu ielādējamo piemēru diapazonu, kas ļauj atlasīt visas datu kopas apakškopu.

# 3. darbība. Savienojiet datu kopasconcatenated_dataset = concatenate_datasets ( [ datu kopa_poz , dataset_neg ] )

Šajā darbībā mēs savienojam divas IMDb datu kopas apakškopas vienā datu kopā ar nosaukumu “concatenated_dataset”. Mēs izmantojam funkciju “concatenate_datasets” un nododam to kopā ar sarakstu, kurā ir divas savienojamās datu kopas. Tā kā abām datu kopām ir vienādas funkcijas, mēs tās savienojam pa axis=0, kas nozīmē, ka rindas ir sakrautas viena virs otras.

# 4. darbība: analizējiet sasaistīto datu kopupozitīvo_atsauksmju skaits = summa ( 1 priekš etiķete iekšā

concatenated_dataset [ 'etiķete' ] ja etiķete == 1 )

negatīvo_atsauksmju skaits = summa ( 1 priekš etiķete iekšā

concatenated_dataset [ 'etiķete' ] ja etiķete == 0 )

Šeit mēs veicam vienkāršu savienotās datu kopas analīzi. Mēs izmantojam saraksta izpratni kopā ar funkciju “summa”, lai saskaitītu pozitīvo un negatīvo atsauksmju skaitu. Mēs atkārtojam, izmantojot ' label” kolonnā “concatenated_dataset” un palieliniet skaitu ikreiz, kad tiek konstatēta pozitīva iezīme (1) vai negatīva iezīme (0).

# 5. darbība. Parādiet rezultātusdrukāt ( 'Pozitīvo atsauksmju skaits:' , pozitīvo_atsauksmju skaits )

drukāt ( 'Negatīvo atsauksmju skaits:' , negatīvo_atsauksmju skaits )

Šajā solī mēs izdrukām savas analīzes rezultātus — pozitīvo un negatīvo atsauksmju skaitu savienotajā datu kopā.

# 6. darbība: izdrukājiet dažus piemērusdrukāt ( ' \n Daži atsauksmju piemēri:' )

priekš i iekšā diapazons ( 5 ) :

drukāt ( f 'Pārskatīt {i + 1}: {concatenated_dataset['text'][i]}' )

Visbeidzot, mēs demonstrējam dažus pārskatu piemērus no savienotās datu kopas. Mēs apskatām pirmos piecus datu kopas piemērus un izdrukājam to teksta saturu, izmantojot kolonnu “text”.

Šis kods parāda vienkāršu piemēru, kā izmantot Hugging Face “datu kopu” bibliotēku, lai ielādētu, savienotu un analizētu IMDb filmu apskatu datu kopas. Tas izceļ bibliotēkas spēju racionalizēt NLP datu kopas apstrādi un parāda tās potenciālu, lai izveidotu sarežģītākus dabiskās valodas apstrādes modeļus un lietojumprogrammas.

Secinājums

Python programma, kas izmanto Hugging Face “datu kopu” bibliotēku, veiksmīgi demonstrē divu IMDb filmu apskatu datu kopu savienošanu. Ielādējot pozitīvo un negatīvo atsauksmju apakškopas, programma apvieno tās vienā datu kopā, izmantojot funkciju concatenate_datasets(). Pēc tam tas veic vienkāršu analīzi, saskaitot pozitīvo un negatīvo atsauksmju skaitu kombinētajā datu kopā.

'Datu kopu' bibliotēka vienkāršo NLP datu kopu apstrādes un manipulācijas procesu, padarot to par spēcīgu rīku pētniekiem, izstrādātājiem un NLP praktiķiem. Pateicoties lietotājam draudzīgajam interfeisam un plašajām funkcijām, bibliotēka nodrošina datu priekšapstrādi, izpēti un pārveidošanu bez piepūles. Programma, kas ir parādīta šajā dokumentācijā, kalpo kā praktisks piemērs tam, kā bibliotēku var izmantot, lai racionalizētu datu savienošanas un analīzes uzdevumus.

Reālās dzīves scenārijos šī programma var kalpot par pamatu sarežģītākiem dabiskās valodas apstrādes uzdevumiem, piemēram, sentimenta analīzei, teksta klasifikācijai un valodas modelēšanai. Izmantojot “datu kopu” bibliotēku, pētnieki un izstrādātāji var efektīvi pārvaldīt liela mēroga datu kopas, atvieglot eksperimentēšanu un paātrināt vismodernāko NLP modeļu izstrādi. Kopumā Hugging Face “datu kopu” bibliotēka ir būtisks ieguvums, cenšoties uzlabot dabiskās valodas apstrādi un izpratni.